Nella corsa all’archiviazione dell’intero World Wide Web (che in questo caso potrebbe essere anche meno Wide) Google da almeno 1 anno a questa parte ha iniziato un processo di folle indicizzazione e scansionamento delle pagine dei siti web senza troppa cura per i dettagli.

Google può leggere i contenuti Ajax/Javascript

Già da tempo esiste questa guida su come rendere i contenuti Ajax leggibili dal Crawler, ma se non si adottano tali tecnicismi pare che il motore sia in grado comunque di leggere contenuti in Ajax. Non è dato sapere in che modo, non è dato sapere fino a che livello qualitativo. Il buon Matt in modo molto curioso annuncia su Twitter:

Googlebot keeps getting smarter. Now has the ability to execute AJAX/JS to index some dynamic comments Se vuoi rispondigli

Poco prima del Tweet di Matt era partito l’annuncio per cui Google sembra in grado di indicizzare i commenti su Facebook, e a pochi giorni di distanza un post abbastanza articolato per domandarsi quanto è abile il bot di Google discusso poi su Google+ da Valerio.

Quando si tocca un terreno così realmente inesplorato bisogna sempre pensarci un po’ su e testare perché altrimenti è davvero facile entrare nel vortice del sentito dire…quindi è bene fare dei test anche su ciò che è dato per assodato. Per i commenti facebook ad esempio quando siamo certi che vengano considerati in tutti i casi o che non sia solo questione di pochi eletti ? O casi sporadici ?

Personalmente anche su siti di una certa rilevanza non ho notato alcun tipo di inidicizzazione per i commenti tramite plugin sociale di Facebook. Voi ?

Al contrario capita invece che il motore e di conseguenza Webmaster Tool segnalino un numero elevato di errori tipo il seguente:

che non dovrebbero essere errori in quanto sono delle URL estrapolate da codice Ajax presente inline nella pagina. Qualcosa simile al seguente (e molto frequente per capirci):

<script> ... var u = "/esempio/text/javascript"; var c = "/esempio_ancora/text/javascript"; ... </script>

mentre non riesce proprio a vedere quello che dovrebbe vedere (se realmente fosse così smart) e che ad esempio il suo Browser Chrome vede e come utilizzando Webkit:

Forse piuttosto che il link nel js sforzati di cercare qualcosa di più utile senza infestare i report errori su Webmaster Tools.

Google può leggere i contenuti Flash e da Object

Da sempre Flash e compagnia bella non vanno di comune accordo con il Crawler e non ne è mai stato fatto segreto anche se pare che il motore sia abbastanza smart e possa leggere e seguire i link all’interno di contenuti flash.

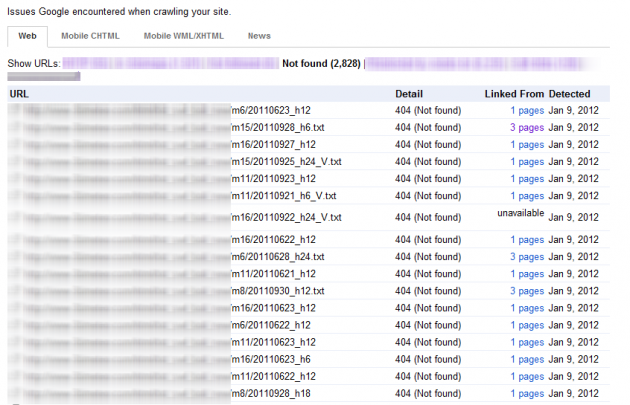

Ne siamo ben felici anche se ci guardiamo bene dall’utilizzare Flash (oggi più che mai con l’avvento di possibili alternative), ma capita però che alcuni script che utilizzano <object> passino tramite un parametro dei file testuali per interpretazione di dati e che non sono di alcun interesse ne per l’utente ne di certo per il motore…sopratutto se nemmeno esistono.

Qualcosa del genere per intenderci:

<param name="FlashVars" value="parametri=txt_swf_boll_new/m15/20120112_h6.txt" /> <param name="quality" value="high" /> <param name="bgcolor" value="#F1F6FA" /> <param name="wmode" value="opaque" />

Anche questo porta ad avere una quantità folle (2,828) di errori 404 da Webmaster Tools perché ovviamente il percorso che viene passato non è sempre quello reale.

Breve riflessione

Spero che tutto questo possa servire a migliorare la ricerca. Spero che tutto questo porti a poter sviluppare applicazioni sempre più complesse in modo sempre più semplice e usabile a livello di interfaccia, ma ho la netta sensazione che ci sia una sorta di ingordigia di contenuti e basta da parte del motore.

Forse sta diventando una gara a “chi ce l’ha più grosso” e per questo bisogna fare sempre di meno e dire sempre di più. [Enrico Madrigrano al Convegno gt ha detto che a volte consideriamo Google migliore di quanto sia e ha confermato anche Enrico Altavilla qui]

La qualità del search si sta forse abbassando per far spazio alla smania di controllo di ogni pezzo di web…anche il più insignificante, anche quello inesistente.

Personalmente questa mattina ho fatto qualche ricerca e tra ricerca personalizzata, geolocalizzazione e minchiate varie non riuscivo a trovare nulla e allora giù di operatori avanzati per trovare quello che cercavo, ma in quanti li usano ?

Siamo sicuro che si vada nel verso giusto da un punto di vista dell’utente ?

E’ davvero utile “averlo tanto grande” se poi non serve nemmeno a beccare meglio la tazza del cesso ?

Forse Google vive da solo e se Piscia di fuori non gli dice niente nessuno.

prova a usare “visualizza come googlebot” per il plugin sociale

A che Pro scusa non capisco ?

..per vedere se becca i commenti lasciati via fb

Vi ricordate quale fu il motivo del successo straordinario di Google? Perchè, rispetto ad Altavista (e altri), si trovava tutto e subito.

Ora con G non accade più, è tutto disordinato e, cavolo, se cerco un video vado su youtube e lo cerco là; se voglio la ricerca “social” vado su G+, Twitter, FB.

G si sta dando la zappa sui piedi. Come è diventato potentissimo potrebbe perdere quote rilevanti, non appena ci sarà un’alternativa valida e la gente inizierà ad usarla e a consigliarla.

Non è così impossibile: la gente che arriva su internet per chattare su Facebook poi impara ad usare altre cose, diventa più competente e la fascia di popolazione web-nativa aumenterà sempre più…

“…la gente che arriva su internet per chattare su Facebook poi impara ad usare altre cose…”

Ma altre cose quale?

bah 🙂

@Lultimo a quale funzionalità ti riferisci ?

Quella del Webmaster Tool ?

Se ti riferisci a quella ovviamente non troverai nulla di utile.

esatto, lo lo strumento in WT.

io non ho blog con il plugin attivato, quindi non posso testare.

Pensavo che però desse la possibilità, vedendo il codice così come lo vede il bot, di verificare la presenza del contenuto di testo dei commenti.