Dopo un lunga vacanza che non facevo da anni, eccomi tornato alla routine pieno di idee e di riflessioni. Come tutti sappiamo, negli ultimi due mesi c’è stato davvero un movimento fuori dal normale relativamente alle contraddittorie azioni di Google in merito ai fatidici link innaturali e i messaggi allarmanti arrivati a tutto il mondo tramite strumenti per webmaster.

Facciamo un breve ricapitolo di cosa è successo nello specifico in questi ultimi 60 giorni, anche se già oramai da tempo le tematiche su cui verte l’attenzione del team antispam e per la qualità dei risultati di Google sono per la maggior parte queste.

L’incipit dell’estate SEO

Possiamo partire in questo arco temporale dall’intervista che Matt Cutts ha rilasciato a StoneTemple dove si parlava di qualità dei siti web, e dove tra le righe si potevano estrapolare informazioni interessanti, ma anche informazioni ambigue che hanno sollevato un bel polverone sopratutto relativamente alle infografiche. È abbastanza evidente che Matt si diverta moltissimo a mischiare le carte in tavola e creare una sorta di confusione, ma questo è in parte un bene per il settore editoriale del mondo SEO in quanto altrimenti ci sarebbero davvero poche news da sfornare e pochi aggiornamenti da poter fornire. Come è ben noto, il mondo SEO è fortemente guidato dalle opinioni piuttosto che dalle certezze e si legge di tutto e il contrario di tutto e, come vedremo, anche Google stesso si comporta un po’ allo stesso modo.

Quello che è certo è che un motore di ricerca è qualcosa di fortemente complesso e dubito fortemente che anche gli stessi ingegneri di Google, che ci mettono la faccia, abbiano una conoscienza piena di quello che esattamente il mix di filtri e algoritmi fanno… ed è anche il bello del motore di ricerca.

Formazione ed evoluzione del mondo SEO che (non) conosciamo

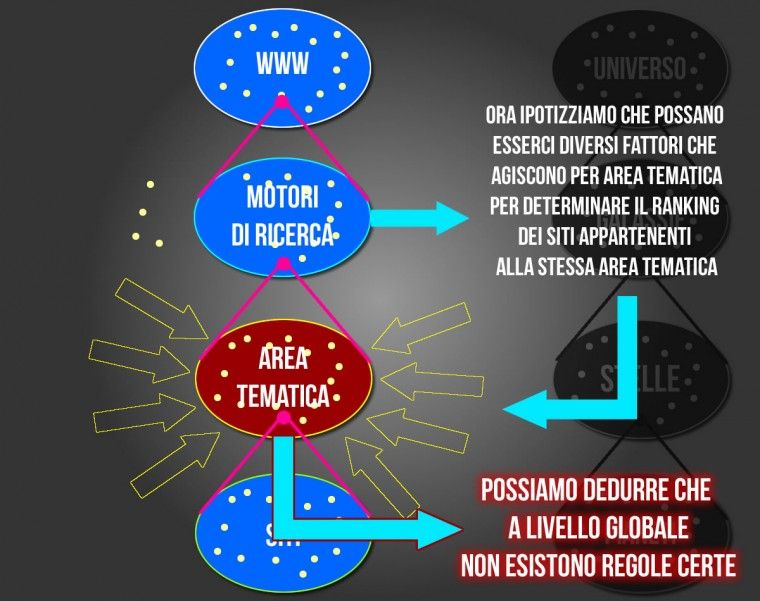

Ipotizziamo che il motore di ricerca sia “in modo grossolano” un sottoinsieme dell’intero WWW, inteso come raccoglitore di una parte (forse piccolissima) dell’intero sistema, e pensiamo che al suo interno il motore di ricerca possa contenere una serie di siti web facenti parte dello stesso settore (diciamo tema) e che questi siti affini siano in un certo senso qualcosa che viene trattato in modo affine e che si evolve in modo autonomo.

È un po come l’universo (WWW) dove abbiamo galassie (Motori di Ricerca) che contengono stelle (Area Tematiche) che contengono pianeti (siti web). Il tutto è molto semplificato e banalizzato, ma penso che possa essere utile a capire quanto può diventare complesso e incerto un sistema di questo tipo e sopratutto quanto lo diventerà con l’andare avanti del tempo.

Ora non voglio dire che il WWW è come l’universo, in quanto è anch’esso per quello che sappiamo una piccola parte del pianeta terra e sarebbe anche velleitario pensare di compararli dato che il secondo risale a circa 13 miliardi di anni fa, ma quello che voglio trasmettere è che molto probabilmente ci troveremo sempre di più a confrontarci con un sistema fortemente in mutazione e che non ha comportamenti predicibili o standardizzabili proprio come non possiamo sapere se al di fuori della terra ci sia vita o che in altre galassie si siano riprodotte le stesse condizioni della nostra. Come non lo sappiano noi, sarà sempre più difficile saperlo anche per le persone coinvolte nello sviluppo dei vari pezzi del motore di ricerca.

Concentrandoci dunque sugli aspetti di ranking dei risultati nei motori di ricerca possiamo pensare che i fattori SEO possono ipoteticamente variare al variare dell’area tematica.

L’azione e l’interpretazione umana non può che creare confusione

Ecco allora che ognuno è costretto a dire la sua, a torto o ragione, e l’estate si vede protagonista di un crescendo di confusione.

Tra il 19 e il 21 Luglio ecco che tutto il mondo viene messo a conoscenza che molto probabilmente ha dei link innaturali verso il proprio sito con la forma identica a quella che solitamente viene usata per segnalare un intervento manuale del team antispam e successivamente dopo aver fatto ammenda dei peccati segue un messaggio peggiore del precedente.

A tutto questo caos è seguito qualche giorno dopo l’intervento di Matt Cutts che avrebbe dovuto chiarire la vicenda dei link innaturali in modo definitivo, ma che forse non ha fatto altro che generare ancora maggiore incertezza.

“Ricevere uno di questi messaggi nuovi non dev’essere un motivo di panico, ma non vanno nemmeno completamente ignorati”

La curiosità sale e anche il crescendo di polemiche in giro per il mondo. Personalmente credo che sia molto difficile creare dei messaggi automatici che possano soddisfare completamente ogni tipo di caso proprio per il discorso appena fatto nel punto precedente. Credo anche che Google tramite la voce di Matt Cutts e sopratutto in Europa grazie agli Hangouts di John Mueller stia facendo molto per comunicare e per cercare di educare in un certo senso la massa stolta. Criticare a priori ogni azione, ogni movimento, ogni cambiamento algoritmico e applicazione di filtri è sicuramente errato così come in alcuni casi può essere errato il comportamente del motore di ricerca o il ragionamento che è dietro a qualche provvedimento.

In un mondo fatto di opinioni è sicuramente difficile mettere d’accordo tutti e ancora più difficile in un mondo dove ci sono interessi e nella maggior parte dei casi la cecità dettata dai personalismi.

Passata è la tempesta odo augelli far festa…

…e il Pinguino, Tornata in su la via…

Ecco che Matt Cutts di nuovo torna a parlare di Penguin update durante un keynote a San Francisco rispondendo in modo molto trasparente a tutte le domande ricevute e successivamente in un’intervista lascia presagire un uragano imminente che arriverà con un prossimo aggiornamento proprio di Penguin.

Come potrete immaginare questo ha scatenato nuove ipotesi e negli hangouts tenuti da Mueller sono state spesso fatte domande sul Penguin update e su quali siano questi oramai famosi link innaturali. Le risposte sono quantomai generiche in molti casi anche perché ipotizzo che gli ingegneri di Google non possano spingersi oltre un certo limite e che in taluni casi non sappiano nemmeno con certezza cosa dire, ma dalle risposte in qualche modo si possono estrapolare delle informazioni interessanti che possono fare anche riflettere.

La contraddizione

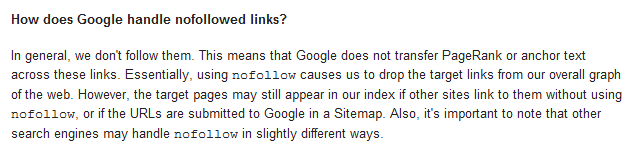

Le linee guida di Google relativamente al nofollow dicono tra le altre cose.

Assistendo all’hangouts si evince che i link innaturali possono essere quelli non a carattere editoriale e dunque auto promozionali in un certo senso. Tra le altre si parla di link sitewide di un certo tipo e di comment spam.

Relativamente ai commenti dunque sorge una grossa contraddizione, o forse anche più di una:

- i link nofollow non dovrebbero in alcun modo essere considerati spam

- a rigor di logica (se non fosse per quel “In general, we don’t follow them”) questi link non dovrebbero aver valore come elemento di ranking

- se io mi chiamo Andrea e commentando nei siti altrui visto che me ne viene data la possibilità posso mettere l’url del mio blog c’è un motivo per cui questo possa essere spam?

C’è una sottile linea che separa ciò che è spam da ciò che non lo è e solitamente c’è una buona attenzione da parte dei possessori di siti sulla revisione di questi commenti. Il problema del comment spamming in un certo senso è qualcosa che ha creato Google (e questo lo conferma) decidendo di trasformare dei link nofollow in elementi spesso determinanti nel ranking di siti exact match.

Nessuno in proprio ha deciso che i link nei commenti servano a manipolare le SERP se non Google stesso. L’attività di partecipazione ai commenti di blog, portali e forum non è altro che una attività di promozione della propria persona e delle proprie capacità così come lo sono altre milioni di forme di marketing, MA SICURAMENTE nel 99% dei casi non è SPAM.

Il mio augurio e la mia tranquillità su questo tema e su Penguin in generale derivano dal fatto che sono fortemente convinto che chi opera e lavora nel team antispam sia ben conscio e abbia abbastanza buon senso da capirlo. Questo è solo un piccolo esempio di come ci sia una contraddizione di fondo tra la comunicazione e trasparenza che si cerca di raggiungere e lo stato reale delle cose. Questo è anche un esempio che mostra come spesso le linee guida e le istruzioni fornite siano ben diverse dalla realtà dei fatti.

Google in ogni sua linea guida è sempre possibilista e non si riserva quasi mai, se non in rari casi, di fornire una certezza del 100% sul funzionamento di qualcosa.

Vi faccio un esempio.

Redirect 301 e Redirect 302

Pensavate di saper giocare con i numerini e con i redirect è? Beh sbagliavate.

Ovunque andrete a cercare leggerete che il 301 è un redirect permenente e che passa pagerank mentre con il 302 il redirect è temporaneo e teoricamente dovrebbe non comportarsi come il 301.

In realtà Google decide in autonomia se un 302 è un 302 oppure un 301. Insomma 2+2 può fare anche 5.

La contraddizione e l’opinione

Oltre alla contraddizione che Google da solo va a crearsi ci si mettono poi le persone!

Spesso queste persone agiscono come veri e propri santoni sul forum di Google indicando la strada alle pecorelle smarrite (che secondo me tanto smarrite non sono)…ma questa strada non è spesso quella giusta o almeno è una strada che difficilmente conoscono e che è basata semplicemente sull’opinione personale.

Di qui tra post da indovino e convinzioni personali nei forum ne nasce una situazione che getta nella bufera la poco consapevole vittima di turno e crea allarmismo e falsità nelle convinzioni di chi teme un crollo.

Succede dunque che tra i candidati principali a causare Penguin vengano messi sul podio non si sa a che titolo e non si sa da chi Directory, Article Marketing e altre attività senza lo straccio di una prova. Personalmente credo che questo tipo di abusi quando ci siano possano semplicemente essere ignorati dal motore di ricerca, ma dubito fortemente che possano essere gli artefici di un problema che con molta probabilità è più vasto. La conferma in un certo senso arriva dagli stessi Cutts e Mueller che non parlano mai esattamente di questi nel caso di Penguin e che nel blog ufficiale viene chiaramente detto (in relazione al secondo messaggio di alert ricevuto negli strumenti per webmaster):

Fundamentally, it means we’re distrusting some links to your site. We often take this action when we see a site that is mostly good but might have some spammy or artificial links pointing to it (widgetbait, paid links, blog spam, guestbook spam, excessive article directory submissions, excessive link exchanges, other types of linkspam, etc.).

Bisogna dunque ponderare e leggere tutte le parole non solo quelle che ci fanno comodo…vedi “excessive” o ascolta negli hangouts “thousand of”.

Oltre a questo bisogna infilarsi nella testa il concetto per cui “non è uno strumento o una attività ad essere non consona, ma il COME lo si usa o la si svolge”.

Riflettere un momento

Basta riflettere un pochino e fare in modo sano un’analisi di quello che si è fatto. Chi sa di aver sbagliato saprà anche come rimediare e non serviranno i lamenti.

Dall’altro lato credo serva una riflessione anche da parte di Google (e credo che la stia facendo) per combinare in modo equo ciò che è buono da ciò che non lo è. Cosa voglio dire? Voglio dire che ci sono moltissimi siti che magari hanno un profilo di link non proprio pulito, ma che osservandoli senza prendere in considerazione questi elementi e da un semplice punto di vista di usabilità e contenuti sono dei siti fantastici, informativi e pieni di valore.

- In questo caso come si comporterà l’aggiornamento di Penguin?

- Valuterà solo gli aspetti negativi o terrà in considerazione in modo pesato anche l’effettiva qualità del sito esaminato?

Qualora non ci sia un ragionamento pesato verranno spazzati via tantissimi siti anche utili e verranno peggiorate le serp portando a galla siti, che non avendo un vero business su Internet non hanno mai avuto l’interesse di curare aspetti qualitativi per l’utente e diventa molto alto il rischio di trovarci di fronte a risultati imbarazzanti.

Pensiamo un attimo a contesti dove difficilmente troverete nelle prime 10 pagine dei risultati di ricerca con siti dal profilo di link pulito. Cosa succederà? Verranno declassati 100 siti e la nostra prima pagina diventarà quella che è ora l’11esima?

Personalmente credo che ne siano consapevoli e credo anche che i prossimi aggiornamenti porteranno ad una svalutazione di alcuni link con la conseguenza che nel lungo periodo diventerà inutile adottare certe strategie.

Credo anche che ci saranno interventi diversi per aree tematiche e che dunque servirà molta attenzione oltre al fatto che tra lingue diverse possano nascere sostanziali differenze di valutazione non applicabili in modo uniforme in un colpo solo.

Conclusione

Con questa manfrina mezza teorica e mezza filosofica (dei poveri ovviamente non sono così filosofo) ho detto molto, ma ho detto poco e niente. Quello che posso concludere dopo questa riflessione è che in parte (pensando in buona fede) sono molto contento delle mosse di Google perché non fanno altro che far spostare sempre di più la concentrazione sulle cose che contano e per chi avrà la fortuna di capire quello che facciamo, consigliamo e spieghiamo noi SEO potrà anche avere un futuro di prosperità e ricchezza.

Una cosa che mi preme di dire a quelli che sono ancora preoccupati e vanno a rincorrere i fantasmi…è quella di non perdere troppo tempo a fare quello che conta poco, ma di iniziare a lavorare sulle cose davvero importanti per la propria fetta di mercato e a livello SEO di pensare a quelle cose appassionanti e che vanno bene in ogni caso anche per aree tematiche differenti ossia:

- performance delle proprie web app

- architettura informativa chiara ed efficace

- rimozione degli errori tecnici e setup dei “must have”

- responsive web design (e/o ottimizzazione del sito per i dispositivi mobili)

- markup strutturato

Tutti argomenti che proverò a trattare in post futuri perché in ognuno di essi c’è davvero tanto da fare e ogni giorno ci sono nuove sfide e nuove idee appassionanti su cui spendere il proprio tempo…anche perché quando crederete di aver terminato qualcosa, ecco che ci sarà sempre qualcosa da migliorare.

Fai sì che all’interno del tuo sito si creino le condizioni idonee ad avere terre fertili e vita sana!

Ottima lettura. Di tutti gli aspetti toccati, e non sono pochi, mi sentirei di mettere sottolineato + grassetto il fatto che Google evita sempre di dare informazioni certe, precise, definite e sicure su qualsiasi cosa. Mi riferisco ai Webmaster Tool, dove si trovano informazioni e dati che, per affermazione del forum, non sono numeri ma stime e approssimazioni e come se non bastasse si riferiscono ad un tempo passato, e come se non bastasse, non si sa quanto passato!

Per rivelare come funzionano gli algoritmi, dicono!

Una cosa folle, dico io.

Spero si capisca lo stesso, mi son perso un “non”:

Per non rivelare come funzionano gli algoritmi

Salve andrea (provo a riscrivere il messaggio con un altra mail perché mi sà che non lo ha preso)

sono il seo di un sito che ha accumulato circa 3000 backlink in 10 anni.

Ora, visto il Pinguino ( e le filosofie 🙂 ) secondo te, se aumento progressivamente i backlink da settembre 2012 ad un ritmo di:

– 40 link a settembre, poi 50 il secondo mese, poi 60 il terzo evia via per sempre

– assicuro per ogni mese, diciamo, almeno 10 backlink di qualità

– questi 10 link hanno P.R. medio 3, molto in tema col mio sito,

– tutti e 40 i link sono senza contenuti duplicati

– tutti e 10 i link sono permalink, permanenti per capirci… faccio un’operazione sbagliata?

Oppure devo marciare su un ritmo di 40 link costante con le stesse caratteristiche appena dette?

Nel secondo caso…come le spingo le key?